Oncrawl: Outil de Crawl et d’analyse de logs

OnCrawl est une solution en ligne qui, comme son nom l’indique, permet de simuler le crawl d’un bot, c’est-à-dire le programme d’exploration d’un moteur de recherches.

Crawler votre site comme un moteur de recherche

Les moteurs de recherches utilisent des bots pour explorer un site web en suivant les liens accessibles dans le code source, permettant de dresser une « carte » du site, c’est-à-dire l’ensemble des URLs qui le constituent. OnCrawl va faire la même chose et ainsi dresser la liste complète des URLs accessibles dans la structure du site. Un fois ce « mapping » exhaustif effectué, il est dès lors possible de repérer un certain nombre de points techniques ou sémantiques bloquants pour le référencement naturel.

Les erreurs remontées par un outil de crawl comme OnCrawl sont nombreuses. Nous allons bien sûr trouver les erreurs courantes comme des liens vers des pages redirigées ou en erreur 404, ou encore les balises Titles trop longues, manquantes ou dupliquées, etc. mais aussi des erreurs plus impactantes comme la volumétrie de pages bloquées au robots.txt ou en Noindex ou bien si les pages critiques d’un site sont suffisamment maillées pour remonter correctement en amont de l’arborescence. Avec un crawl, il est donc possible d’aller très loin dans la découverte de chantiers d’optimisations SEO. C’est l’étape obligatoire pour s’assurer qu’un site est techniquement sain.

Analyseur de logs: comprendre ce que Google voit (ou ne voit pas)

L’autre avantage d’un outil comme Oncrawl est sa fonction d’analyse de logs. Les fichiers logs sont un journal de bord horodaté listant l’ensemble des événements qui se sont produits sur un serveur, en l’occurrence, des demandes de connexion par des ressources externes. Dès que vous souhaitez accéder à une URL d’un site web, les logs enregistrent votre IP, ainsi que l’heure et la date de votre visite. Il est donc capable d’identifier si vous êtes un internaute lambda ou bien un bot crawleur de Google venu explorer le site. Avec les logs, nous sommes donc capables de savoir qui et quand, bot ou humain, est venu sur notre site.

En couplant une analyse de logs avec un crawl sur Oncrawl, nous sommes donc capable de faire correspondre notre mapping du site avec les logs, et donc savoir quelles sont les pages actives, c’est-à-dire visitées par les internautes sur une période donnée, mais aussi quelles sont les pages explorées par les moteurs et à quelle fréquence. Un crawl couplé à une analyse de logs mettent en lumière des problèmes techniques très importants qu’il serait impossible de détecter autrement, comme par exemple un gros volume de pages orphelines régulièrement crawlé par les moteurs de recherches, ou bien Google boudant une partie de nos pages critiques.

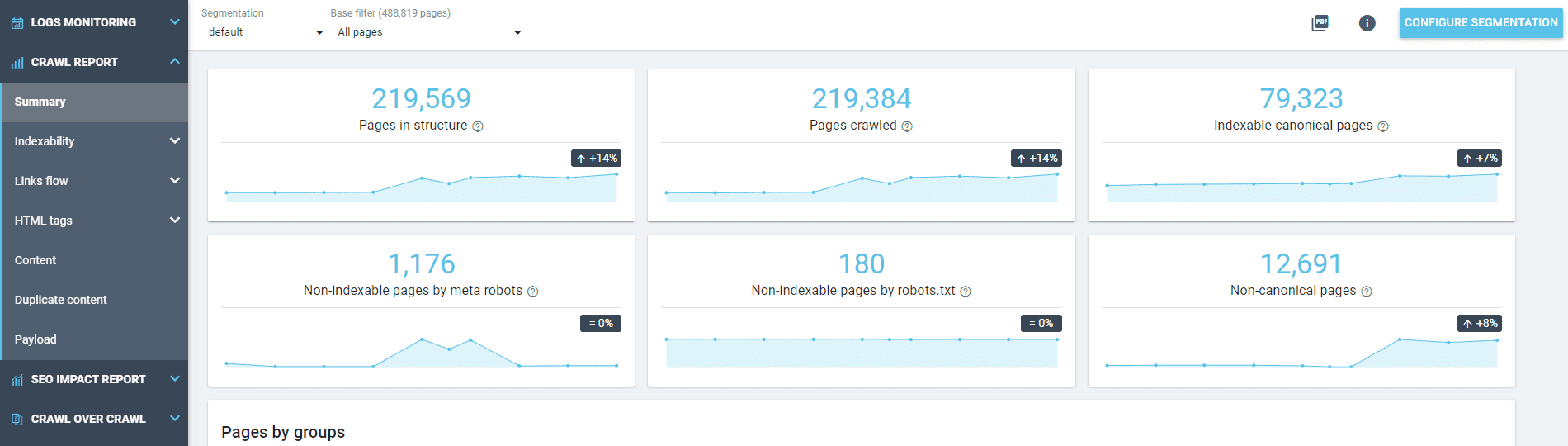

Quelles KPIs regarder sur OnCrawl ?

Il est possible de passer beaucoup de temps sur OnCrawl tant les informations disponibles sont nombreuses. Toutes les données fournies sont pertinentes à un moment donné, mais si nous devions établir un TOP 5 des KPI à regarder en premier lieu, ce serait :

- Le volume de pages dans la structure : correspond-il au nombre de pages qui, à ma connaissance, sont présentes dans mon site ? Si ce volume est trop petit ou trop important par rapport à mon estimation, il y a un problème.

- Les volumes de pages non indexables (en Noindex, bloquées au robots.txt ou non-canoniques) : quelle proportion ces pages occupent-elles dans la structure de mon site ? Est-ce une part importante ? Quel volume de liens entrant ces pages reçoivent-elles ?

- Répartition du Page Rank par profondeur : Quelle structure à mon site ? Est-ce que mes pages importantes sont situées à moins de trois clics de ma home page et reçoivent-elles suffisamment de Page Rank ?

- Status code de mes pages : Est-ce que les pages en redirections (301, 302) ou en erreur (404, 500, etc.) constituent une part importante de mon volume global. Si oui, des corrections s’imposent.

- Le volume de duplications de Balises Titles et H1 : Un rapide coup d’œil vous indiquera si de la duplication est présente sur mes pages et en quelle proportion.

Une prise en main plutôt technique

OnCrawl nécessite quelques compétences pour tirer le meilleur parti de l’outil. La configuration initiale pour lancer un crawl nécessite d’avoir une bonne compréhension initiale de votre site à auditer. Un gros site de plusieurs dizaines de milliers de pages sera plus long à explorer qu’un site de 400. La partie analyse de logs, en revanche, nécessitera de connaître les Regex pour catégoriser vos URLs, passage obligé pour identifier quelles typologies d’URLs sont concernées par les problèmes que vous détectez. OnCrawl est donc, en définitive, un outil plutôt réservé à une personne ayant déjà de bonnes connaissances en référencement naturel.