Comment améliorer le crawl grâce à la correction du maillage interne ?

Ecrit par Erik Chiaramonti

le

Parfois, on a beau essayer toutes les optimisations possibles, on ne parvient pas à faire décoller un site. On crée du contenu, on augmente de façon exponentielle son nombre de pages, on multiplie les liens, bref, on enrichit un maximum son site mais rien n’y fait. Pire que tout : malgré nos actions, le site dégringole, et se retrouve finalement boudé par Google.

C’est arrivé au site dont nous parlons aujourd’hui, qui s’est retrouvé avec cette donnée glaçante : 95% de ses pages non explorées par les robots. On vous explique comment nous avons réussi à inverser la tendance, et retrouver un crawl à 100% grâce au maillage interne.

Beaucoup de pages…et beaucoup de couacs

Notre analyse concerne un site spécialisé dans l’immobilier en France, avec une forte volumétrie de pages. Forcément, qui dit immobilier, dit beaucoup d’annonces : près de 433 000 urls y sont ouvertes à l’indexation. Malgré ce grand nombre et un secteur immobilier florissant, le trafic reste en berne depuis plusieurs années.

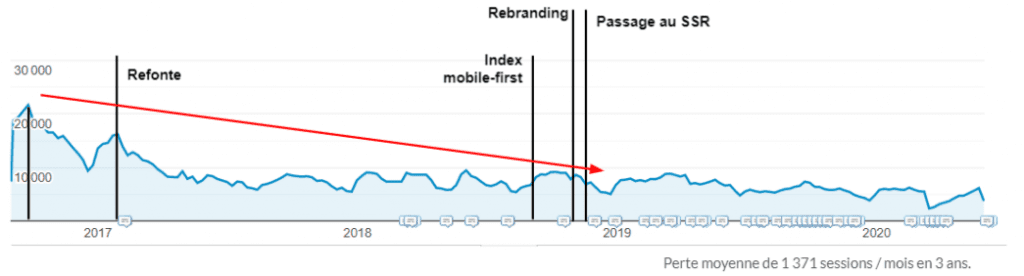

Suite à plusieurs refontes mal orchestrées, un rebranding, et un passage au SSR (Server Side Rendering) non sans couacs, le trafic du site est en berne. La pilule est difficile à avaler : après son essor jusqu’en 2017, le trafic organique se retrouve au bout de 3 ans divisé par 3 !

On le sait : un site techniquement propre est un prérequis essentiel à tout chantier de croissance. Si nous voulons inverser la tendance, il est donc nécessaire dès le début du projet de reprendre la problématique depuis la base : l’analyse de l’indexation.

Un site boudé par les robots de Google

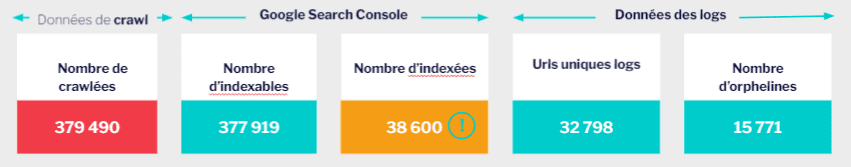

Notre objectif est d’identifier la source du problème. Le point de départ est donc de confronter les données de crawl et des logs du site aux résultats d’indexation depuis Google Search Console. Et le constat est sévère :

- Google ne visite que 5% du site (logs)

- Les visites SEO se font sur uniquement 22% des pages indexées (logs)

- 27% de ces visites sont sur des pages orphelines (logs + crawl)

- 99,5% du site est ouvert à l’indexation (crawl)

- 97% des pages sont inactives (logs + crawl)

En bref, le site est boudé par les robots d’exploration. Pas étonnant que le trafic ne soit pas au rendez-vous.

Pour trouver comment y remédier, nous devons comprendre les raisons de ce délaissement. Nous posons donc nos hypothèses.

Pour quelles raisons Google choisit-il de délaisser un site ?

Parce qu’il ne considère pas le site comme pertinent ou bien ne le comprend pas. Et plusieurs hypothèses peuvent l’expliquer :

- Le contenu n’est pas optimisé : les mots clés cibles ne sont pas travaillés sur les pages et les balises SEO ?

- Le contenu proposé sur le site ne correspond pas à la recherche des internautes : nous cherchons à positionner des pages avec un template inadapté aux mots clés visés ?

- Le contenu est défaillant, faible, dupliqué, incorrect : le rendering SSR empêche-t-il aux robots de voir le contenu des pages ? Les pages sont-elles vierges de tout contenu rédactionnel ? Ou bien ce contenu est-il de piètre qualité ?

- Le contenu n’est pas convenablement accessible pour le robot : une mauvaise crawlabilité des pages causée par un maillage déficient ?

Notre attention se porte tout d’abord sur la question du rendering, car John Mueller, notre ami de chez Google nous le dit depuis longtemps “L’indexation de sites modernes développés en Javascript est un challenge.” Au regard des performances vertigineusement basses du site, ce point nous semble être une évidence.

Et pourtant, après avoir mené nos vérifications auprès des développeurs quant à la bonne configuration du SSR, nous comprenons que nous faisons fausse route. Le doute sur un problème de rendering désormais levé, nous nous attardons sur nos hypothèses restantes.

Celles de l’optimisation du contenu, et de sa pertinence ne pouvant pas empêcher la découverte des pages du site, notre regard se porte alors sur la crawlabilité du site, son maillage.

Refondre la structure : une structure saine pour un site sain

Pour avancer efficacement sur notre audit du maillage interne, un travail préparatoire d’identification des priorités est nécessaire. Nous devons focaliser les efforts sur le contenu qui représente un réel potentiel, valoriser son accessibilité aux robots, et assurer sa bonne indexation selon un ordre de priorité. Et cet arbitrage passe par les volumes de recherche.

a) Identifier les pages prioritaires et élaguer les pages sans potentiel

Après avoir interrogé nos nombreux mots clés et obtenu leur volume de recherche, nous créons un arbre de décision qui nous permet d’obtenir 3 types de pages :

- Pages à valoriser absolument : qui représentent un intérêt pour l’utilisateurs mais aussi pour le business et qui ciblent des mots clés avec un volume de recherche intéressant

- Pages à retirer de l’indexation : qui représentent un intérêt pour l’utilisateur et le business, mais qui ciblent des mots clés avec un volume de recherche nul

- Pages à supprimer : les pages qui n’ont pas ou plus d’intérêt business, ni utilisateur.

De quoi nous fixer un cap et des objectifs appuyés sur la data. Maintenant que ce corpus est créé, il devient notre base d’analyse. Il nous permet alors de mettre en évidence un problème lié au trop grand nombre de pages.

b) Créer des pages en masse : une fausse bonne idée ?

La forte volumétrie des pages du site est-elle pertinente pour notre site ? En tant que bon SEO, nous savons que pour chaque page, il nous faut travailler un seul groupe de mots clés. Mais tous les mots-clés sont-ils bons à cibler ?

Dans notre cas, l’analyse nous montre que non : l’ouverture à l’indexation d’une page pour chaque localité française n’est pas une bonne stratégie. Pire : elle pourrait jouer un rôle dans les mauvaises performances des 2 dernières années.

On compte plus de 36 000 villes en France, et toutes ces villes ne représentent pas toutes des volumes de recherche intéressants. Multipliez ce chiffre par le nombre de types de biens (appartement, maison, studio, etc.) et de transactions (achat, location) vous vous retrouvez avec des milliers de pages indexables sans aucun potentiel de trafic.

Nous précisons notre objectif initial : pour que Google cesse de bouder notre site, nous devons le diriger vers nos pages qui représentent un réel potentiel. Et cela passe par le retrait des pages qui polluent notre crawl.

En parallèle, nous devons identifier les pages qui, elles, représentent un vrai potentiel. Pour cela nous nous appuyons de nouveau sur notre analyse préparatoire des volumes de recherche. Nous pouvons alors comparer la cohérence entre l’état du maillage et les objectifs constatés.

C) Maillage, maillage

Pour auditer le maillage, nous vérifions simplement si les pages au meilleur volume de recherches sont les plus maillées. L’analyse de crawl met en évidence que ce n’est pas le cas : le type de page le plus stratégique n’est pas le plus maillé.

Ce type de page n’est que 5ème dans le classement, loin derrière d’autres pages moins stratégiques, plus éloignées de la conversion, comme les pages édito par exemple.

Il ne nous en faut pas plus pour comprendre que les actions à mener concernent les dispositifs de maillage. Et pour cela, nous allons passer chacun d’entre eux en revue en les confrontant aux objectifs et à la concurrence.

Nous dégageons ainsi les chantiers d’optimisations qui vont nous permettre d’agir sur la bonne découvertes de nos pages. Ces chantier sont :

- le menu de navigation

- le footer

- le(s) plan(s) de site

- le maillage depuis la page d’accueil

- les fils d’ariane

- la pagination

- les blocs de maillage entre pages catégories

- les blocs de maillage entre les pages annonces

- les blocs de maillage des pages annonces vers les page catégorie

- les liens contextuels, présents dans le contenu édito.

Pour chacun de ces dispositifs, la réflexion s’articule autour 2 points :

- Classer la nature des liens : Quelles sont les pages qui font le lien vers quelles autres pages ?

- Sur quelle ancre de lien ?

Sur les sites à forte volumétrie de page, l’attention sur les ancres de lien et leur poids sémantique est un levier d’optimisation à ne surtout pas négliger. Les divers maillage doivent être :

- cohérent avec les mots-clés cibles de la page de destination

- varié pour éviter toute sur-optimisation et élargir le spectre sémantique

- complémentaire entre eux.

Les chantiers à mettre en place :

Voici les modifications mises en place, suite à notre audit sur chacun de ces éléments de maillage.

a) Menu de navigation

Plus de 70% des liens présents dans le menu de navigation renvoient vers les autres sites du groupe. Un important point d’incohérence qui aura tendance à perdre les robots.

Imaginez plutôt : plus de 433 000 pages qui font des liens en masse vers d’autres sites. Cela n’encourage pas les robots d’indexation à passer du temps sur le notre ! En correctif, nous valorisons les pages de notre site dans le menu de navigation, et réservons les liens vers les autres entités du groupe à un endroit moins stratégique et qui ne se réplique pas sur toutes les pages.

[ Plus de lien = plus d’importance ] Plus une image est maillée plus le signal envoyé est que la page est importance

[ Mais attention, trop de lien tue le lien ] Plus il y a de lien, moins le lien à du poids. Un lien accessible sur l’intégralité des pages depuis le menu de navigation par exemple a moins de poids sémantique qu’un lien unique et contextualisé dans un texte. N’oublions pas que Google fonctionne désormais selon la logique du “surfeur raisonnable” et que les liens ne sont pas tous logés à la même enseigne en termes de poids SEO.

b) La page d’accueil

Limiter les liens depuis sa page d’accueil, c’est comme limiter l’accessibilité de vos produits dans la vitrine de votre magasin. Dans notre cas, la homepage est limitée au niveau de son linking, et ne renvoie que vers quelques annonces. Nous avons donc enrichi cette dernière en permettant d’accéder aux pages selon un regroupement par thématique, toujours en s’appuyant sur les volumes de recherche. Inversement nous avons retiré les liens vers les pages moins stratégiques.

c) Le footer et plan de site

Peu de constats du côté du footer, si ce n’est d’y privilégier l’accès au plan de site.

Un plan de site que nous avons actualisé, et divisé en plusieurs sous-plans thématiques, en fonction de chaque type de bien. Cela dans le but d’assurer un niveau de profondeur limité, tout en donnant efficacement accès à l’ensemble des pages stratégiques.

Avec ce plan de site hiérarchisé, Google n’aurait donc qu’à suivre le lien du footer pour s’engouffrer dans une arborescence parallèle lui permettant de visiter (enfin) tout le site.

d) Le fil d’Ariane

Ce prérequis essentiel à toute bonne structure de site peut rapidement s’avérer être un casse-tête sur les sites à forte volumétrie de pages.

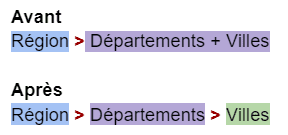

Dans notre cas, c’est un peu le bazar. Notre problématique est d’arriver à faire s’enchaîner de manière cohérente les (nombreux) types de pages. Car nous avons réussi à mettre en évidence des conflits dans le fil d’Ariane : l’arborescence est plate entre les différents types de bien (maisons, appartement, etc.) et les différentes transactions existantes (achat, location, investissement, etc.).

Notre objectif est donc de hiérarchiser efficacement. Pour cela 3 actions sont mises en place :

- Placer les transactions en haut de l’arborescence (avant les échelles de localité – région, département et ville) afin de valoriser 3 chemins descendants différents,

- Limiter l’affichage à 4 items maximum,

- Ne pas prendre en compte le nombre de pièces dans le fil d’Ariane, que nous avons choisi de réserver au bas des pages listes.

e) Maillage inter-catégories

Les conflits d’arborescence évoqué avec le fil d’Ariane, sont également à prendre en compte au niveau des liens situés en bas des pages listes, pour respecter une certaine cohérence. Pour cela 3 actions sont mises en place :

- Respecter la hiérarchisation dans les liens présents en bas de page. Par exemple, une page Région ne doit faire des liens que vers sa catégorie enfant, à savoir les départements. Le département ne doit faire que des liens vers les villes. et ainsi de suite.

Diviser le nombre de liens de moitié. Comme nous l’évoquions, trop de liens tue le lien. Puisque chaque page fait plus de 50 liens vers d’autres pages, nous préconisons de limiter les liens par page à 25, afin d’obtenir un maillage plus fin. N’oublions pas qu’un maillage prend la forme d’une toile, et qu’elle doit être complexe pour être efficace. Vous avez déjà vu une araignée tisser sa toile à l’horizontal, vous ?

Les Résultats :

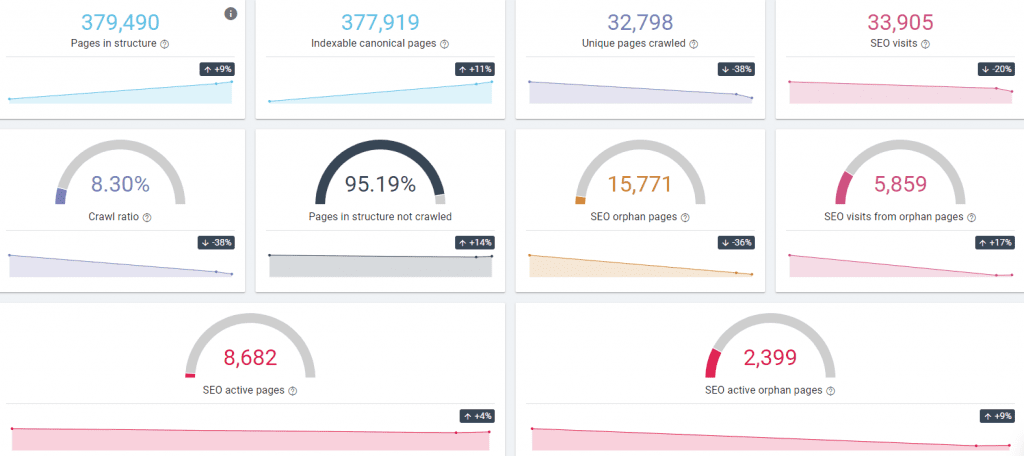

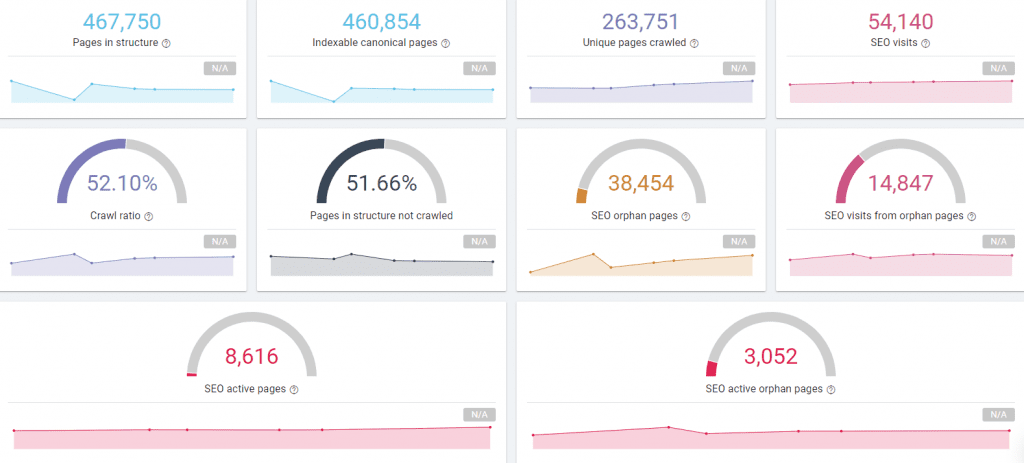

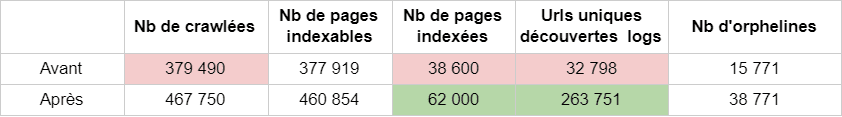

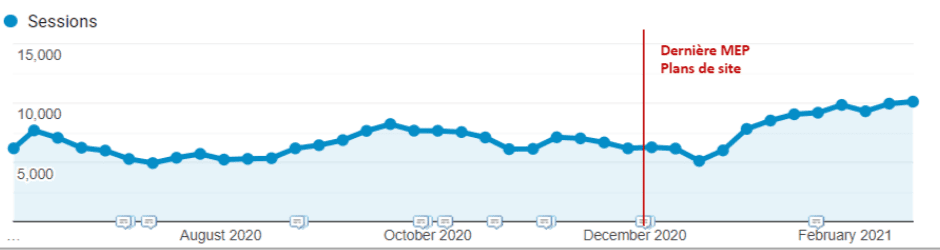

Après 7 mois d’implémentation de chacun des correctifs, voici le résultat : un site qui n’est plus boudé par Google. On multiplie par 2 le nombre de pages indexées, et surtout, notre donnée principale : on multiplie par 8 le nombre de pages découvertes par les robots d’exploration !

100% de nos pages stratégiques sont, a minima ,découvertes par google. On est pas encore à 100% découvertes – pardonnez le titre tape-à-l’oeil – mais les résultats sont là, et nous avons rempli notre objectif : le site commence à retrouver sa place auprès des moteurs de recherche.

Et l’impact n’est pas que technique : ces actions nous ont permis d’avoir une augmentation de trafic de 30% vs N-1 et 40% vs N-2, sans même toucher au contenu.

Bien sûr, la découverte de l’intégralité des pages stratégiques par les robots d’indexation nous aura permis de mettre en évidence d’autres problèmes d’indexation que nous ne soupçonnons pas.

Si grâce à nos optimisations, Google parvient à découvrir nos pages stratégiques, il déterre également les vieux fantômes, qui sont autant de nouveaux sujets à traiter. De quoi alimenter un nouveau plan d’action. Comme quoi, si l’on attend des résultats, l’optimisation SEO ne s’arrête jamais.