Tout savoir sur les robots d’explorations/user-agents Google pour le SEO

Ecrit par Killian Lemoal

le

Les agents utilisateurs, ou user-agent en anglais, servent à identifier le logiciel utilisé pour accéder à un site web ou à un autre service en ligne.

Plus précisément, l’agent utilisateur est une chaîne de caractères envoyée par le logiciel client (par exemple, un navigateur web, un robot d’indexation, un lecteur multimédia) au serveur. Elle contient des informations sur le logiciel, telles que :

- Le nom et la version du logiciel : par exemple, « Chrome 98 » ou « Googlebot 2.1 ».

- Le système d’exploitation : par exemple, « Windows 10 » ou « Android 12 ».

- La langue : par exemple, « fr-FR » ou « en-US ».

Pourquoi Google utilise des users-agent ?

Google utilise plusieurs agents utilisateurs pour plusieurs raisons principales :

1. Identifier et différencier ses différents robots d’exploration

2. Collecter des données sur différents navigateurs et appareils

3. Détecter et bloquer les spams et les abus

4. S’adapter aux différents sites web et serveurs

5. Tester et déboguer les problèmes

Quels sont les robots d’explorations utilisés par Google ?

Dans la recherche Google : Googlebot

| User-agent | Jeton de user-agent | Chaîne de user-agent |

| Googlebot pour smartphone | Googlebot | Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) |

| Googlebot pour ordinateur | Googlebot | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Googlebot/2.1; +http://www.google.com/bot.html) Chrome/W.X.Y.Z Safari/537.36 |

| Googlebot Image | Googlebot-Image | Googlebot-Image/1.0 |

| Googlebot News | Googlebot-News | N/A |

| Googlebot Video | Googlebot-Video | Googlebot-Video/1.0 |

| Google StoreBot | Storebot-Google | Pour ordinateur : Mozilla/5.0 (X11; Linux x86_64; Storebot-Google/1.0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Safari/537.36 Pour mobile : Mozilla/5.0 (Linux; Android 8.0; Pixel 2 Build/OPD3.170816.012; Storebot-Google/1.0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 |

Dans les outils Google : Googlebot

| User-agent | Outil | Jeton de user-agent | Chaîne de user-agent |

| Google-InspectionTool | – Test de résultats enrichis – Inspection des URLs dans la Search Console | Google-InspectionTool | Mobile : Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Google-InspectionTool/1.0;) Ordinateur : Mozilla/5.0 (compatible; Google-InspectionTool/1.0;) |

| GoogleOther | Tests internes à Google | GoogleOther | GoogleOther |

| Google-Extended | Gemini | Google-Extended | N’existe pas |

Les users-agents Google liés à des fonctionnalités : Extracteurs déclenchés par l’utilisateur

| User-agent | A quoi sert-il ? | Jeton de user-agent | Chaîne de user-agent |

| Feedfetcher | Utilisation des flux RSS pour Podcast et actualités | FeedFetcher-Google | FeedFetcher-Google; (+http://www.google.com/feedfetcher.html) |

| Centre pour les éditeurs de Google | Intégre et exploite les flux d’informations explicitement partagés par les éditeurs via le Centre pour les éditeurs de Google, en les affichant sur les pages de destination de Google Actualités. | N/A | GoogleProducer; (+http://goo.gl/7y4SX) |

| Google Read Aloud | Récupère et lit les pages Web à l’aide de la synthèse vocale. | N/A | Ordinateur : Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.118 Safari/537.36 (compatible; Google-Read-Aloud; +https://support.google.com/webmasters/answer/1061943) Mobile : Mozilla/5.0 (Linux; Android 7.0; SM-G930V Build/NRD90M) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.125 Mobile Safari/537.36 (compatible; Google-Read-Aloud; +https://support.google.com/webmasters/answer/1061943) |

| Google Site Verifier | Récupère les jetons de validation de la Search Console. | N/A | Mozilla/5.0 (compatible; Google-Site-Verification/1.0) |

Documentation officielle de Google :

- https://developers.google.com/search/docs/crawling-indexing/overview-google-crawlers?hl=fr

- https://developers.google.com/search/docs/crawling-indexing/googlebot?hl=fr

- https://developers.google.com/search/docs/crawling-indexing/verifying-googlebot?hl=fr

Combien de robots d’exploration Google possède-t-il ?

Google ne communique pas le nombre exact de robots d’exploration qu’il utilise. Le nombre est en constante évolution et dépend de plusieurs facteurs, tels que la quantité de contenu à explorer, la fréquence des mises à jour des sites Web et la disponibilité des ressources.

Comment détecter le user-agent Googlebot ?

Il existe différentes méthodes afin de comprendre les moyens mis en oeuvres par Google pour comprendre votre site web :

- Les logs serveurs : si vous avez accès aux logs de votre serveur web, vous pouvez les analyser pour rechercher les agents utilisateurs utilisés par Google. La plupart des journaux de serveur web enregistrent l’agent utilisateur de chaque requête, ce qui vous permet de voir quels robots d’exploration Google accèdent à votre site web. Il est même possible de mener une analyse de logs afin de comprendre le comportement de Google.

- La Search Console : en analysant une URL, l’outil vous donne la possibilité de découvrir de multiples détails techniques liés à la découverte de votre URL et notamment le user-agent utilisé par Google.

Comment optimiser la gestion des user-agent sur Google via son robots.txt ?

Dans le cas d’un site web indexé sur Google, il est essentiel de contrôler les user-agents qui vont visiter votre site.

Le fichier robots.txt est un outil essentiel pour gérer les agents utilisateurs de Google sur votre site web. Il vous permet d’indiquer aux robots d’exploration de Google quelles parties de votre site web ils peuvent explorer et lesquelles ils doivent ignorer.

Le robots.txt se compose notamment d’une partie User-agent (en plus d’une partie directive) qui permet de déterminer une règle à chaque ligne imposée pour un user-agent unique. Par exemple, User-agent: Googlebot. C’est ce qu’on l’on appelle un jeton d’agent.

Vous pouvez également définir et des autorisations et des restrictions. Utilisez les directives Allow et Disallow pour contrôler ce que chaque agent utilisateur peut faire. Par exemple :

User-agent: Googlebot

Allow: /public/

Disallow: /private/

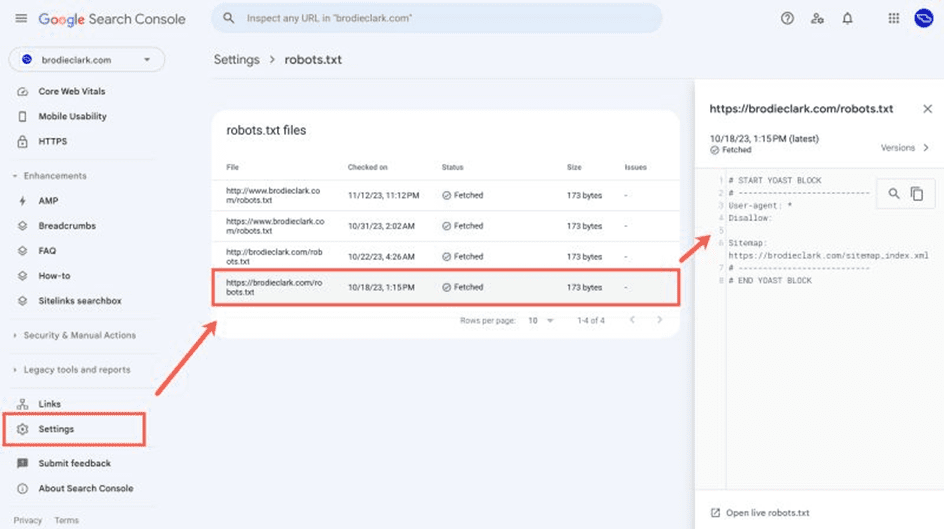

Pour être sûr de ne pas commettre d’erreur, vous pouvez tester votre robots.txt via la Search Console qui permet même d’y faire du monitoring.

Découvrez bientôt notre grand guide sur le fichier Robots.txt !

Comment réduire la vitesse de crawl de Googlebot ?

Un peu accrocheuse, ce titre permet de se poser préalablement une autre question : peut-on réduire la vitesse de crawl de Google ?

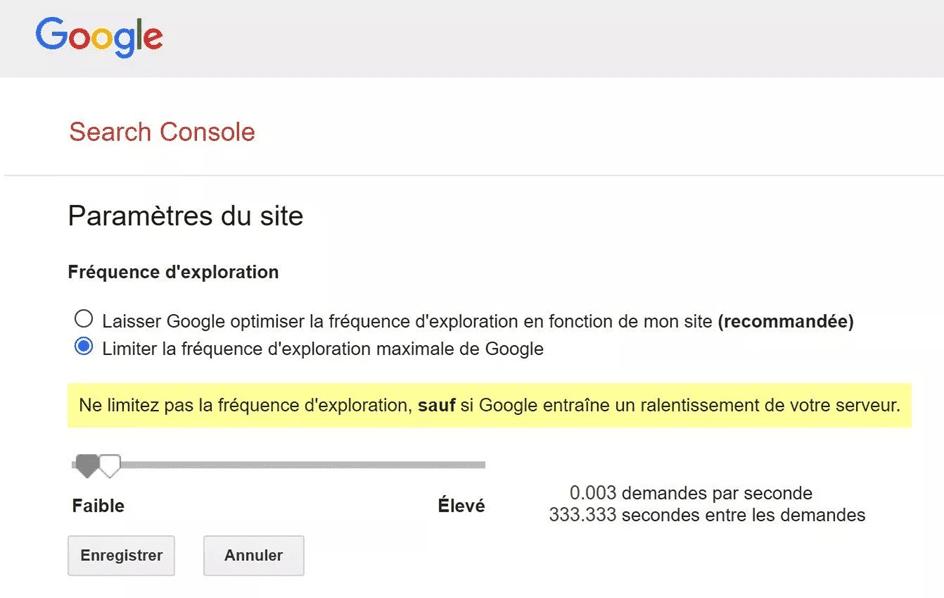

Depuis plus de 10 ans, Google permettait de réduire manuellement la vitesse de son user-agent Googlebot au sein de la Search Console. En fin 2023, Google décide de faire marche arrière en supprimant cette fonctionnalité. La firme américaine demande aux propriétaires de sites de laisser faire l’algorithme d’adaptation automatique du crawl.

Google exige, il existe une différence entre ses annonces et ses actes. Ainsi, la page d’aide permettant de Réduire la vitesse d’exploration de Googlebot existe toujours. Il y est même indiqué comment limiter la vitesse de crawl de Googlebot, malgré que Google déconseille fortement cela.

Voici ce que google dit : « Notre objectif est d’explorer autant de pages de votre site que possible à chaque visite, sans surcharger la bande passante de votre serveur. Dans certains cas, l’exploration de votre site par Google peut entraîner une surcharge critique sur votre infrastructure ou des coûts indésirables lors d’une panne. Pour remédier à ce problème, vous pouvez décider de réduire le nombre de requêtes effectuées par Googlebot. »

Mais alors, comment réduire le crawl de Google ? Il suffit de lui faire renvoyer sur vos pages des codes HTTP 500 ; 503 ; 429. Si cela n’est pas possible, vous pouvez alors faire une demande spéciale : https://search.google.com/search-console/googlebot-report?hl=fr

Documentation officielle : https://developers.google.com/search/docs/crawling-indexing/reduce-crawl-rate?hl=fr