Ranking Factors 2013 dans l'algorithme de Google (étude Search Metrics)

Ecrit par Peak Ace

le

Le jeudi 30 mai 2013, nous avons eu l’immense plaisir d’organiser un petit déjeuner avec SearchMetrics, notre partenaire stratégique. Pour ceux qui ne connaissent pas encore Search Metrics, il s’agit de la solution leader de suivi de campagnes SEO/SEA/Social. Marcus Tober, le fondateur de Search Metrics, a animé ce petit déjeuner en compagnie du directeur de notre agence, Philippe Yonnet.

Le thème du petit déjeuner était dédié aux dernières évolutions de l’algorithme de Google ainsi qu’aux facteurs de classements 2013 pour la France. Cela fait maintenant 3 ans qu’une nouvelle étude est menée chaque année par des sites très populaires dans l’univers du SEO. La première qui marqua les esprits fut réalisée par SEO moz en 2011, avec plusieurs milliers de partages. SearchMetrics a bien emboîté le pas puisque cela fait maintenant 2 ans qu’ils présentent leur étude des critères de classements de Google. En 2012, ils sortent une étude basée sur plus de 10 000 mots clés et 300 000 sites qui remporta un franc succès.

Marcus Tober et son entreprise ne se sont pas arrêtés en si bon chemin et nous on fait l’honneur de présenter en exclusivité l’étude 2013 des facteurs de classements de l’ algorithme de Google.

Avant de nous lancer dans l’analyse de cette étude, rappelons quelques principes et la méthodologie utilisée par Search Metrics permettant d’arriver aux résultats. Ceci nous permettra de ne pas tirer de fausses conclusions.

Tout d’abord, l’étude a été réalisée sur Google.fr, cela signifie que les facteurs de classements tirés de l’étude concernant uniquement l’algorithme de Google France. Ensuite, l’étude a été menée sur le top 30 des résultats Google en analysant 300 000 urls sur 10 000 mots clés. Les résultats ne concernent bien évidemment que les résultats organiques. De plus, l’étude a été menée avec l’utilisation de moyenne pour ne pas biaiser les résultats provenants de mots clés avec des fort volumes de recherches. Enfin, l’étude est basée sur une relation de corrélation statistique entre les facteurs de classements de l’algorithme et un bon classement dans Google. En ce sens, si par exemple on trouve une majorité d’urls dans les tops positions de Google avec un title qui contient le mot clé étudié, nous pouvons conclure qu’il y a une forte corrélation mais ce n’est pas pour autant une relation de causalité. « Correlation is not causation » qui est souvent utilisé par les scientifiques, résume bien la situation. La corrélation est une relation de dépendance tandis que la cause est une relation de conséquence.

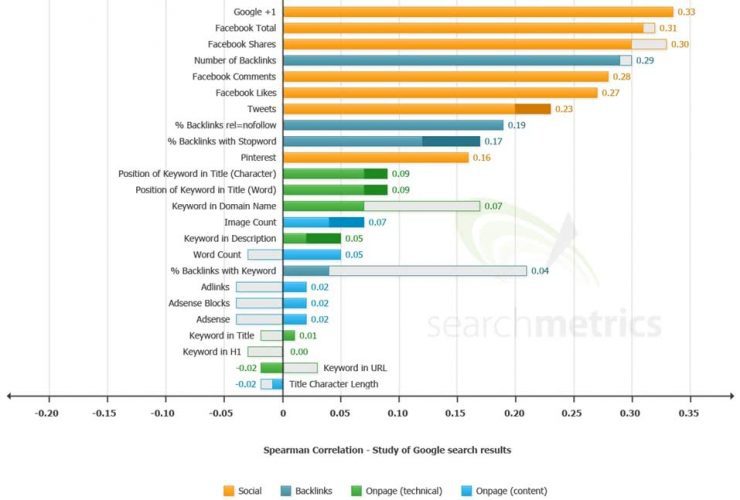

Maintenant que nous avons brièvement récapitulé les principes de l’étude menée par Search Metrics, voici ci dessous l’évolution des facteurs de classements 2013 vs 2012 :

Premiers constats :

La première surprise est l’apparition de Google Plus comme facteur de classement ayant la plus forte corrélation avec des bonnes positions dans Google. Nous savons que Google Plus est de plus en plus utilisé (bien poussé par Google) mais le voir avec une corrélation supérieure aux backlinks et signaux sociaux issus de Facebook est intéressant. A ce sujet, un article est à venir sur la supériorité de Google Plus sur Facebook dans l’impact sur les positions. Dans l’étude menée en 2012 par Search Metrics, le facteur Google Plus n’avait pas été pris en compte. Aujourd’hui cela confirme bien qu’un site avec beaucoup de partages Google Plus est corrélé avec de bonnes positions.

Derrière Google Plus, se trouve les signaux issus de Facebook qui perdent légèrement en poids par rapport à 2012 (-10 %) dans les critères de classements de Google. Cependant les signaux sociaux Facebook ont toujours une corrélation supérieure avec des bons rankings que les backlinks ! Ces derniers, même si leur poids diminuent légèrement restent toujours aussi prépondérants dans l’algorithme de Google avec la 3ième corrélation la plus forte derrière Facebook et Google Plus. On regrette cependant que la distinction ne soit pas faite entre les liens entrants et les domaines référents. Cela nous permettrait de mieux appréhender si la diversité des liens est aussi importante qu’on ne le présume.

Le nombre de backlinks en no follow est toujours un facteur bien placé dans les critères de classements et reste stable en terme de poids comparé à 2012. Ce pourcentage de no follow crédibilise votre profil de liens, ne pas hésiter donc à acquérir quelques liens sans « juice ».

Enfin l’utilisation d’un mots clé étudié présent dans le H1 aurait une corrélation neutre avec de bons rankings alors que cela pouvait être négatif en 2012 selon Search Metrics. Cette balise est donc beaucoup moins importante qu’auparavant mais ne soyons pas parano, l’utiliser à bon escient n’est pas négatif pour votre SEO.

Les grands gagnants :

Le premier grand gagnant de cette étude est Twitter dont la corrélation avec de bons classements augmentent de 15 % ! On note également l’apparition de Pinterest dans l’étude de Search Metrics, qui est un des facteurs les plus corrélés avec un bon classement dans Google. Un critère dont on entend peu parler « % backlinks with stopword » a pris énormément de poids dans l’algorithme de Google avec une augmentation de 40 % dans sa corrélation positive. Un stop keyword est défini par l’utilisation de ponctuation, conjonctions dans vos ancres de liens. La raison est toujours la même : depuis Penguin Google s’attache à accorder plus d’importances aux liens avec des ancres naturelles. Alors n’hésitez plus à utiliser des longues ancres dans l’acquisition de vos liens !

Le nombre de caractères et la position du mots clé dans le titre de la page est toujours important dans l’algorithme de Google comme le montre leur corrélation qui augmente légèrement. Restez donc concis et ciblés dans l’utilisation de vos balises titles ! On notera également que les mots clés lorsque présents dans la meta description ont une corrélation positive avec de bonne positions. Cela semble plutôt logique si le taux de clics augmente parallèlement !

Par ailleurs, les sites disposant de contenu multimédia (images) sur leur site tendent à avoir de meilleurs positions que les sites sans images. Cependant la corrélation est très faible et ceci peut s’expliquer par le fait que les sites disposant de beaucoup d’images sont souvent des marques qui sont la plupart du temps bien considérés par Google. Couplés avec le facteur « word counts », Google aurait donc tendance à plus privilégier les sites riches en contenu qu’auparavant (lutte contre le contenu de mauvaise qualité). Attention cela ne veut pas dire qu’il faut privilégier la quantité à la qualité !

L’autre surprise concerne le nombre de mots dans le contenu des pages étudiés. En effet en 2012, le nombre de mots présents dans une page avait une corrélation négative avec de bons classement et c’est désormais l’inverse !

Enfin, cette année les sites avec de l’Adsense ou bien des liens d’affiliations n’ont plus une corrélation négative avec des bons classements. En effet Google lutte contre les sites qui utilisent de la publicité à outrance (mise à jour Google above the fold), ce qui pouvait être néfaste pour leur référencement. Aujourd’hui selon l’étude Search Metrics, l »utilisation de liens publicitaires tels que Adsenses ou autres aurait une corrélation très légèrement positive, qu’on peut estimer comme neutre. Il faut simplement veiller à ne pas dépasser un seuil critique.

Les grands perdants :

Sans grande surprise, l’utilisation d’ancres avec des mots clés ciblés a perdu énormément de poids dans l’algorithme de Google (-400 % !!). Depuis Google Penguin, les premiers sites à se faire pénaliser sont ceux qui ont une profil de liens contenant une majorité d’ancre de liens optimisés sur des mots clés. Il faut donc toujours maintenir une proportion d’ancres « brandés » pour rester sous le radar de Google.

Une informations qui en réjouira certains d’entre vous (ou pas!) : les EMDs (Exact Match Domain) et l’utilisation du mot clé dans un nom de domaine tendent à moins bien se positionner dans Google qu’en 2012 (-140 %). Dans la même lignée, l’utilisation du mot clé dans l’url qui était corrélé positivement avec des bonnes positions en 2012, est désormais très légèrement négativement corrélé.

Conclusion

Cette étude ne doit pas être utilisée comme un évangile mais nous donne de bonnes indications sur l’évolution de Google et sa manière de classer les sites. Depuis l’ère Panda et Penguin, les sites utilisant des techniques de manipulation de l’algorithme de Google sont de plus en plus nombreux à tomber à chaque mise à jour algorithmique et manuelle. Aujourd’hui pour être bien positionner dans Google de manière durable, il est important de miser sur une stratégie de contenu riche avec l’utilisation des différents multimédias à votre disposition (images, vidéos, texte). Se créer une identité sur internet c’est faire connaître sa marque, être reconnu par son contenu de qualité.

Lorsque cette stratégie mis en place est réussie, viennent ensuite les signaux de qualité que Google va prendre en compte dans son algorithme. La première cible reste les partages sur Google Plus, vous ne pouvez pas vous passer de ce réseau social si vous ne souhaitez pas vous faire distancer par vos concurrents. Google a bel et bien décidé de le pousser sur le maximum de supports et l’utilisera de plus en plus dans la construction de son futur algorithme, notamment avec le Google Authorship

Les backlinks sont toujours aussi importants et le seront toujours même si ils le sont moins qu’avant au détriment des signaux sociaux. Les sites les mieux positionnés sont toujours ceux qui détiennent le plus de liens entrants dans l’étude de Search Metrics. Il faut seulement investir dans une stratégie de netlinking qualitative et naturelle. La sur-optimisation et l’acquisition de liens de basse qualité en masse ne fonctionnent plus et pénaliseront votre site.

Merci à toute l’équipe Search Metrics et plus particulièrement à Marcus Tober pour cette belle étude ! Pour information, Search Foresight organise régulièrement des petits déjeuners qui abordent divers sujets sur les stratégies d’Inbound Marketing et le SEO. Chaque petit déjeuner amènera à un article qui retranscrira la pensée de Search Foresight.