Les directives noindex dans le robots.txt seront elles supportées demain ?

Ecrit par Mathieu CHAPON

le

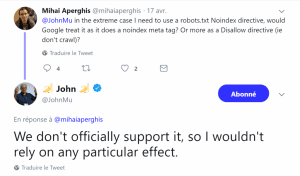

Cela fait des années que Google supporte les directives noindex dans les fichiers robots.txt. Mais cela fait aussi des années que Google explique que ce support n’est pas officiel, et que du coup il était possible que Google change son comportement à un moment donné.

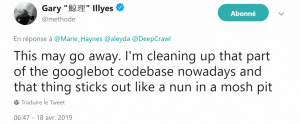

Si l’on en croit les derniers propos de Gary Illyes sur Twitter, ce changement est peut-être pour bientôt !

« Si vous voulez visser quelque chose, il faut utiliser un tournevis, pas un marteau »

Visiblement, les équipes de Google réfléchissent à « nettoyer » un certain nombre de fonctionnements jugés non cohérents. En principe, le fichier robots.txt a été conçu pour définir ce que les bots des moteurs de recherche étaient autoriser à télécharger sur un site, mais pas du tout pour contrôler la façon dont les contenus sont indexés dans les moteurs de recherche.

La plupart des autres moteurs s’en tiennent à un support beaucoup plus strict de la norme définie en 1994 pour les contenus des fichiers robots.txt, le « robots exclusion protocol (REP) », et dont on trouve les détails ici :

http://www.robotstxt.org/

Bref, la directive « noindex » n’est pas supportée sur les moteurs concurrents

Bref, selon certaines personnes de Google, dont Gary Illyes, il est plus logique de clarifier les choses en forçant les webmasters à utiliser le bon outil pour maîtriser l’indexation des pages, à savoir une balise meta robots avec comme valeur d’attribut « noindex », ou une directive x-robots-tag dans le header http de la page, pour les documents qui ne sont pas en html (les pdf, ou les images par exemple).

Qu’est-ce que cela implique pour mon site ?

Pour le moment, l’arrêt du support de la directive noindex a été sérieusement évoquée, mais rien n’est décidé encore. Mais l’alerte est suffisamment sérieuse pour :

- vérifier si vous avez une telle directive dans votre fichier robots.txt (situé à la racine de votre site)

- et si c’est le cas, de chercher à remplacer ces directives par une implémentation correcte (meta robots, ou x-robots-tag) dans les meilleurs délais