Le SEO technique n'est pas de retour, il n'était jamais parti

Ecrit par Mathieu CHAPON

le

Il assez amusant de constater que des cycles de conférence consacrés au SEO Technique refleurissent dans les conférences anglo-saxonnes sur le Search. Les sujets techniques ont l’air de revenir à la mode.

Mais pourquoi ? Qu’est-ce qui a changé pour justifier un tel regain d’intérêt ?

Le SEO a toujours été en partie technique

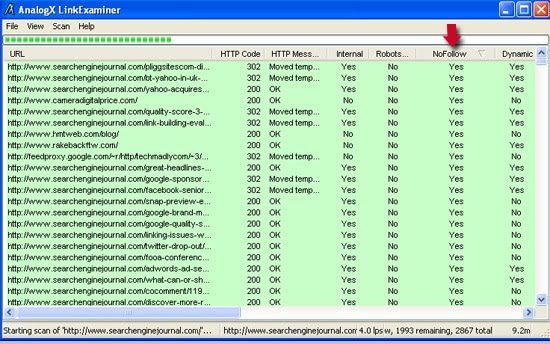

Si l’on remonte dix ans en arrière, optimiser un site demandait déjà de bonnes bases techniques. Dès que l’on cherchait à savoir pourquoi certaines pages n’étaient pas crawlées, ou indexées, il fallait savoir analyser des logs (et les outils du marché comme Botify ou Oncrawl n’existaient pas), crawler des sites (et Screaming Frog n’existait pas), et puis bien sûr comprendre l’origine de tous les obstacles techniques qui pouvaient empêcher un moteur de recherche de télécharger et analyser correctement le contenu d’un site.

Déjà à l’époque, le SEO n’était pas uniquement qu’un sujet technique, et les aspects contenus ou popularité étaient, selon les sites, soient considérés comme stratégiques ou complémentaires, mais toujours comme importants.

Donc ce n’est pas une mode : les aspects techniques étaient importants dans le SEO, et le sont toujours.

Alors qu’est-ce qui a changé ?

Les SEO sont confrontés à de nouveaux challenges techniques

Ce qui est nouveau, et qui conduit une nouvelle génération de référenceurs à s’intéresser aux aspects techniques, c’est que de nombreuses évolutions du web en général et de Google en particulier créent de nouvelles difficultés au quotidien.

Tout d’abord, la montée en puissance des usages mobiles a conduit au code responsive et à de nombreux challenges pour le SEO, comme par exemple gérer le masquage ou l’affichage du contenu ou des liens de navigation selon le device utilisé.

Côté mobile, les pages AMP, ou les Progressive Web Apps viennent changer considérablement la façon dont on conçoit des contenus pour mobile ou des applications.

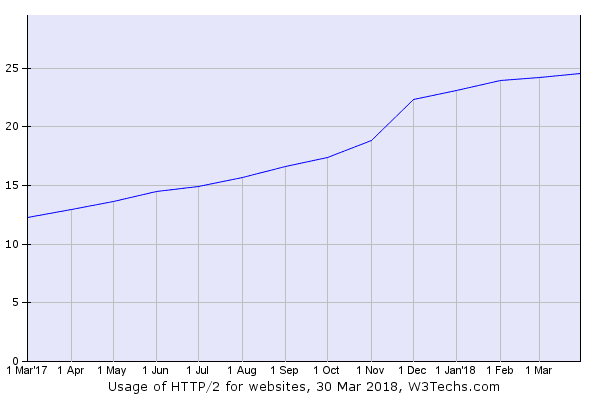

Plus généralement, le web change : les sites web doivent supporter des connexions sécurisées désormais, et on passe au http2. Les sites deviennent beaucoup plus déconcentrés et sont souvent maintenant des assemblages de données issus de web services, qui eux-mêmes évoluent fortement (avec de nouvelles approches comme GraphQL).

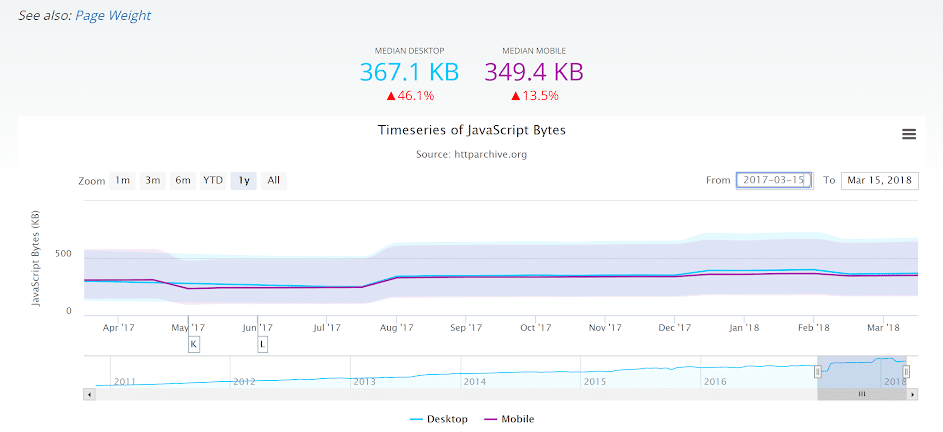

En parallèle, l’usage du javascript s’est répandu. Avec comme conséquence le fait de voir apparaître des sites entièrement en Ajax, ou faits avec des frameworks javascript, difficilement crawlables ou indexables par les moteurs.

En même temps, les moteurs ont tous commencé à faire un usage intensif des données structurées, et il a fallu ajouter des balises schema.org sur les pages, avec des implémentations (comme le Json-LD) toujours plus techniques.

Pour finir, le fait que Google parvienne à présent à crawler et indexer les contenus en javascript a changé la donne, et oblige les référenceurs à revoir leurs méthodes (adieu l’obfuscation des liens) et à changer de paradigme pour continuer à auditer des sites sans faire de grossières erreurs d’appréciation.

Conclusion : Un référenceur en 2018 doit comprendre toutes ces nouveautés pour accompagner des clients (ainsi que leurs équipes techniques) qui ont de plus en plus de mal à suivre à chaque nouveauté, et qui ne comprennent pas les implications nouvelles pour le SEO.

Le SEO technique a vraiment de beaux jours devant lui.