Changement dans votre robots.txt : votre site peut être bloqué par Google !

Ecrit par Peak Ace

le

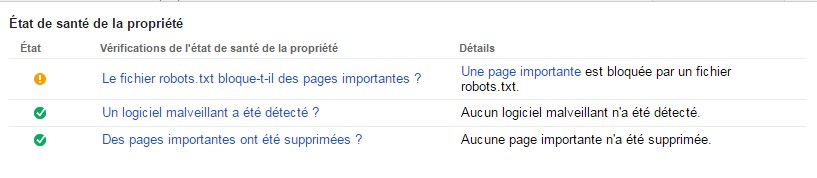

Coup de tonnerre dans votre Search Console ! Depuis quelques jours, des webmasters ont pu voir apparaître des alertes dans leur Search Console indiquant qu’une page importante pouvait être bloquée à l’exploration de Google.  Alerte Search Console : une page importante est bloquée par le robots.txt. Ce message n’est pas à prendre à la légère, car votre site entier pourrait être bloqué à l’exploration de Google. En effet, si vous avez une règle dans votre robots.txt du type : Disallow: *blablabla , cela risque de bloquer votre site à l’exploration de Google.

Alerte Search Console : une page importante est bloquée par le robots.txt. Ce message n’est pas à prendre à la légère, car votre site entier pourrait être bloqué à l’exploration de Google. En effet, si vous avez une règle dans votre robots.txt du type : Disallow: *blablabla , cela risque de bloquer votre site à l’exploration de Google.

Comment vérifier si mon site ou une page importante est bloquée par le robots.txt ?

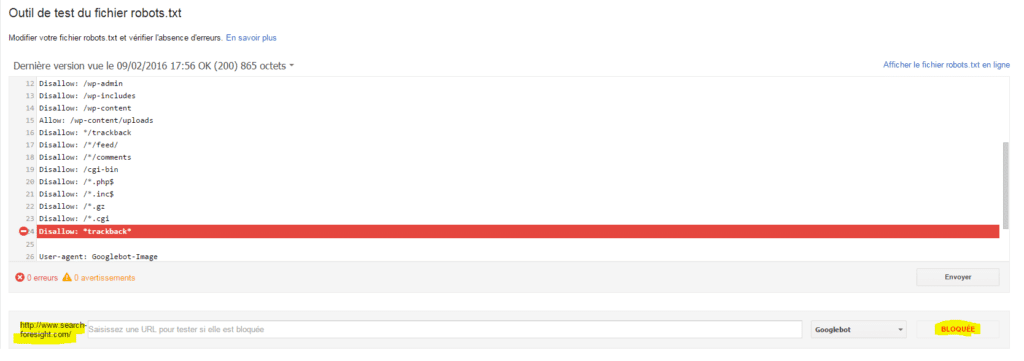

La première chose à faire est de vérifier si vous avez reçu une alerte dans votre Search Console (anciennement nommé Google Web Master Tools). Si vous avez reçu une alerte (cf ci-dessus), cliquez sur « une page importante » pour connaître la page qui est bloquée par votre robots.txt. Ensuite, vous devez vous rendre sur l’outil de test du robots.txt dans votre Search Console et regarder quelle est la directive de votre fichier qui pose problème. Ne rentrez rien dans le champ de l’url à tester, afin de requêter la home page et regarder la directive qui pose problème. Exemple du robots.txt de notre site qui posait problème :

Cette directive ne posait pas de problème auparavant, mais Google semble avoir fait un changement brutal de sa tolérance syntaxique dans le robots.txt. D’ailleurs en testant d’autres pages de notre site sur l’outil de test, toutes nos pages étaient bloquées à cause de cette directive *trackback*.

Comment corriger votre directive robots.txt fautive ?

En rajoutant un « / » juste avant votre directive commençant par un « * », vous allez régler le problème. Dans notre cas nous avons changé notre directive en Disallow: /*trackback* au lieu de Disallow: *trackback*. En témoigne notre nouveau robots.txt N’oubliez pas de vérifier si la nouvelle règle ne bloque pas d’autres patterns utiles. C’est très étonnant (ou pas ?) de la part de Google qui n’a pas pris la peine de communiquer sur le sujet. Il faut donc communiquer cela d’urgence à votre webmaster ou votre agence sous peine de rencontrer des mauvaises surprises.